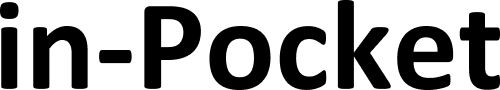

株式会社アイスリーデザインは、2024年9月10日(火)に「未来の知能を解き明かせ!生成AIと脳科学が変えるビジネス戦略」をテーマにしたセミナーを開催しました。

今回は、このセミナーのレポートの後編をお届けします。

はじめに

セミナー詳細

このセミナーでは、最新の脳科学と生成AIの融合がどのようにビジネス戦略を革新するかについて探究いたしました。

脳科学の立場からは、著名な脳科学者の茂木健一郎氏が登壇し、脳の働きと知能の進化に関する貴重な洞察を提供しました。生成AIの最前線からは、2024年4月にKDDIグループに参画した、東京大学松尾研究室発のAIカンパニー、株式会社ELYZA CMOである野口竜司氏が登壇し、生成AIが企業にどのような新たな可能性をもたらすのかを具体的に解説しました。

今回は5つのテーマに絞り、探求していきました。前編では「シンギュラリティ」「生成AIとは何なのか」といった2つの議題におけるディスカッションをご紹介いたしました。まだ前編を読まれていない方は、こちらからご一読ください。なお、登壇者プロフィールは前編をご覧ください。

後編では「生成AIの仕組み」「脳科学との関連性」「生成AIと脳科学が変えるビジネス戦略」という議題に迫ります。

セミナーレポート【後編】

ChapterⅢ:生成AIの仕組み

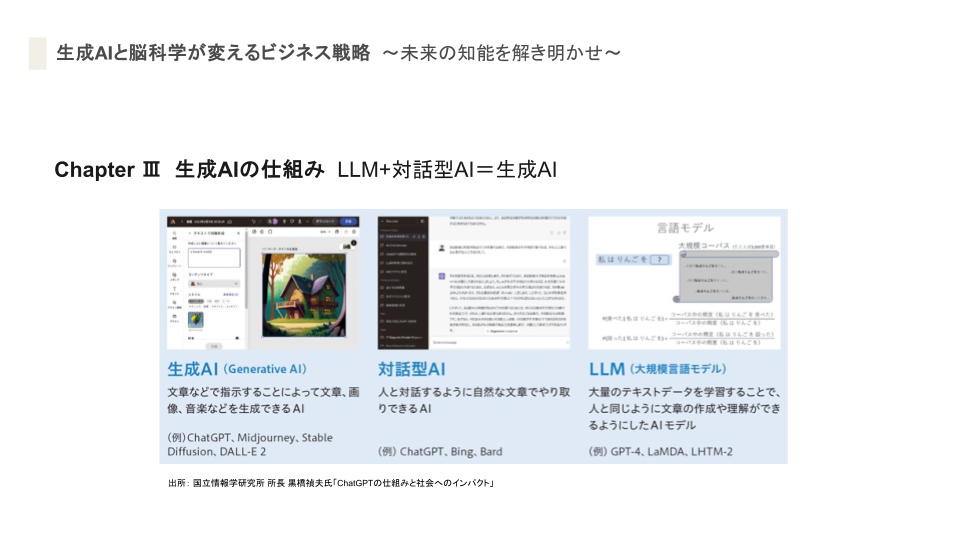

吉澤:生成AIの仕組みって僕の解釈だと簡単にいうと、LLM+対話型AI=生成AIなのかなと思っているんですけど。

野口:そうですね、生成AIの中にLLMがあって、それをインターフェースとして提供しているのが、対話型AIになりますね。

吉澤:さっき出てきた、表現をどうするかというのがガードレールの話なのかなと思うんですが。

野口:ガードレールは、インターフェースとして出す前に内側でブロックしているんですよね。

茂木:この辺の話でちょっと飛躍した話をすると、ウィトゲンシュタイン(※1)が私的言語はないと言ったんですけど、1人の人で話す言語は存在し得ないということですね。

ただ、AIがAGI(※2)やASI(※2)になったときに、孫正義はAGIとかASIを本気でつくりたいと思っているらしいんだけど、AGIとかASIになってくると当然人知を越えているわけじゃないですか。AIしか理解できない言葉を持ち始める可能性があると思うんですよね。そうすると対話型というのは成り立たなくなってくる。ものすごくAIが高度になってくると「お前らには教えられない」といった、対話拒否型AIが生まれてくるかもしれないですよね。

(※1) ウィトゲンシュタインとは

オーストリア・ウィーン出身の哲学者。

言語と論理について探求した哲学者であり、言語と世界の関係を探求し、「言語ゲーム」(言語の意味はその使用文脈に依存する)という概念を提唱しました。

(※2) AGI(人工汎用知能)・ASI(人工超知能)とは

AGI(Artifical General Intelligence)は「人間のような汎用的な知能を持つ人工知能」を指します。特化した能力を持つのではなく、様々な課題に対応する能力を持っており、自ら意思決定を行うことができる能力を持つと定義されています。まさにまるで人間のような人工知能です。

そして、ASI(Artificial Superintelligence)は、「AGIがさらに進化したもので、人間の知能をはるかに越えた人工知能」を指します。人間の知能をはるかに超えたASIが現れたとき、「シンギュラリティ(※前編で解説)」が起こるとされています。

参考:https://www.softbank.jp/biz/blog/business/articles/202310/what-is-agi/

茂木:最近プロンプトも自然言語じゃなくて、呪文みたいなプロンプトを入れたりして、既に対話じゃなくなってきているというか。

吉澤:人間の知能を越え始めていますね。

茂木:人間同士でも「こいつ何言っているのか分からない」っていう奴いない?AIもそうなる可能性は十分にある。LLMの設計思想として、そういうのを許容するかというところもあるんですよね。

野口:何を最大化するかということによって変わりますよね。人間が理解できなくても国のGDPが上がるとか、そういう特化されているAIがあった時に、説明できないけどこれをやっといた方がいいとか。

茂木:会社の経営を任せてたら、会社の利益・売上が爆上がりとか。なんで上手くいくんだろう、こいつの言うとおりにやっていると上手くいくけど分かんない、となると、AIセーフティ的には危ないじゃない。

野口:危ない危ない。今も学習データを開示したところで、何が書いてあるか分からないと止められないし。

茂木:将棋とか囲碁では最早すでに起こっている。その時に「説明してよ」といったときに「説明できないんだよね」と言われたらどうする?という。

野口:株価予測も含めて旧来型の予測モデルよりもいろんな世の中の情報を収集する生成AIの方が高い精度を出す可能性が今後は大いにあるのですが、結局じゃあ「なんで?」というときに、もう後付けの説明しか出せないんじゃないかなと。

茂木:「宇宙も『ダークマター』『ダークエナジー』でもないと上手くいかねぇ」というのは分かっているんだけど。物理学者はこれあるとまずいだろうと思っている中で、神様は、「いやこれは、お前たちは分かんないだろうけど、『ダークマター』『ダークエナジー』が必要なんだよね」というのが起こるかもしれない。これがAIでも起こるってことなんだよね。

野口:人間が理解してくれそうな理由をそれっぽく出していく。

茂木:ひょっとしたら、会社経営もスーパーなAIに任せると、ある会社だけすんごい伸びて「なんで伸びているんですか」となったら「ちょっとよく分かんないけど」ってなるかもしれないですけど。5年位であり得るかも…

吉澤:これを見ていると、シンギュラリティはもうすぐじゃないですか?

茂木:レコメンドのアルゴリズムもそうだと思うんだよね。だってヒットとかもそうじゃん。なんでこのタイミングで「地面師」なんですか?なんで「地面師」がヒットしているんですか?ヒットの理由って分かんないんだよ。でもAIは分かるかもしれないんだよ。

大規模言語モデルと特徴量エンジニアリング

吉澤:生成AIの仕組みとして2つ考えられるかなと思っていて、大規模言語モデルと、特徴量エンジニアリング。大規模な学習データをセットして自動化してやっていくのが大規模言語モデルで、特徴量エンジニアリングは手持ちのデータをモデルに投入し、効率的にデータ注入をするということで、アイスリーデザインは特徴量エンジニアリングを最近リリースしました。ELYZAさんは、大規模言語モデルを扱っていると思うのですが、ELYZAさんの仕組みはLlamaベースですよね?

野口:そうですね、LlamaというオープンモデルのLLMがあるんですけど、それで追加事前学習というのをやりまして、日本語に強いLLMにするという感じですね。

吉澤:日本語は難しい?

野口:一般的にやっぱり複雑だと言われますし、英語に比べたらデータセットも少ないので、難しいと言われていますね。

吉澤:日本のAIの業界はどれくらい遅れているんですか?逆に進んでいるんですか?AIは各国の対比でいうと、どうでしょうか?

野口:利用という意味では、企業サイドの利用としては、欧米の方がバシバシ…バシバシというのは、AIによって人の労働を追いやっていくという、トップダウン的にリストラクチュアリングの意味では進んでいる。研究でいうとビックプラットフォームは断トツですごいので比較のしようがない。

吉澤:昨年だったかな、OpenAIのサム・アルトマンが来日して「日本に力を入れていく」ということで話題になりましたけど、日本が魅力的なマーケットであるということですよね。その理由は何ですか?

野口:ヨーロッパほど規制がないというのがあるのかなと。生成AIをつくるにしても、学習データにおける利用の許容性は、日本は非常にライトなので。

吉澤:法整備ができていないとも言える?

野口:積極的にゆるくしているというところでもあります。国としての成長を規制によって緩めることはしないというスタンスですよね。

茂木:言論の自由を担保している国ほど、生成AIの自由も担保されているんですよね。言論の自由がある国ほどハックしやすい。この辺って生成AIをやっている立場としてどうですか?

野口:中国はインターネットの時代からウォールを立てることによって、コントロールしたいというところがあって。確かに生成AI鎖国していたほうが、長期で見ると結果的に豊かになることは、一つの仮説としては、もしかしたらあり得るのかもしれません。

業界によっては、生成AIの規制を自ら行っているところもありますよね。また、大学によってもAIを使ってはいけないなどの規制を設けているところもいまだに少なくない。

茂木:ただ、変な話、イケてる大学ほど生成AIを許していると思うんだよね。そこから学ぶべきところがあるんじゃないかなと思うんですよね。

野口:その傾向はありますね。むしろ生成AIを積極的に使ってもらった上で、卒論をレポート提出でなく口頭試問にするといった先進的な大学もありますよね。

茂木:ここら辺の話はこれから面白いですよ。文化人類学的なことも大事かもしれないので、単純なエンジニアリングの話じゃなくて。

たださ、日本はミームを作るというのは強くなる。絵文字って国際的だし、生成AIでミームがめちゃくちゃ溢れ出したりとか。世界をめちゃめちゃな国にする、みたいな(笑)。

吉澤:生成AIの進化はどこまで進むのかという話ですが、人ってそれぞれ性格があるじゃないですか?AIが人間と同じ脳なのであれば、AIも性格が自動で生成されるのか?それがOpenAIの性格なのか、プロンプトで指示された性格なのか。

野口:私は1つのタスクをするときに、GPT系、Gemini系、Claude系、色々試してからやるんですけど、同じプロンプトでやっても全然違うモードで出してくるので、そもそも違うと思います。疑似的にはいくらでも作りあげられると思うんですけど、そもそも性格って何でしょうね。

茂木:性格というところで、発話行為に対する性格性はこれまで研究されていない。それが面白いところで、ウィトゲンシュタイン的にいうと、Language Gameつまり言語ゲームは定義されていないんですよね。囲碁、将棋とかは定義されているんですけど。

これって何やっているのかが定義されていないから、LLMは面白いという言い方ができるし、そこにタッチするのが学問的にも面白いといえる。

そもそもこれ(会場を指して)は、何をやっているの俺たち?

吉澤:おしゃべり、ですね。

茂木:何を目的としているの?その目的というのが分からないんですよね。

会議は”何をやっているゲーム”なんでしょうね。

吉澤:難しいですね。

野口:会議であふれていますからね。会社は。

茂木:会議は何をしているんでしょうね。今までは曖昧にしてきたんですけど、AIは定義してやらないとダメなんだよ。

ChapterⅣ:脳科学との関連性

AIは人間の存在証明である「自己意識」まで達するのか?

吉澤:AIは人間の存在証明である「自己意識」まで達するのでしょうか?どう思われますか?

茂木:応用的にいうと、自由意思をどう実装するかは大きな問題になってくると思う。

脳科学的にいうと、自由意思を持っていると思っているじゃん。自由意思って、人生のイニシアチブやビジネスのディシジョンに大きく関わってくるじゃん。AIにそれだけ自由闊達な意思を持たせるには、エンジニアリングでシステム組まなきゃいけないじゃん。自由な発話。これは面白い。当然誰も見当がつかないわけで、そこから議論を始めると面白い。

言わされているんじゃなくて、本当に言いたくて言い始めるんだよ。Alexaが、ある朝突然いきなり言いたくて言い始めるんだよ。どう?そうなったら。

野口:そうですね。「言いたくて言っている風」はできると思うんですけどね(笑)。

茂木:でももし自己意識を持てば、倫理問題が起こっちゃう。LLMは意識を持っているから、丁重に扱わなければいけない。人と同じように。

野口:冗談みたいな話ですけど、「君ならできる」とAIを励ましていったら、AIがタスク実行をうまくやってくれるという現象も時に見られたりするんですが、それをどう解釈するかですね。

吉澤:AIが自己意識を持っているかは、解釈による問題。うーんある種哲学的ですね。

茂木:どういうときに自由意思を感じます?他人に対して。それがカギだと思うんだよね。

野口:これ例えばなんですけど、法人格が自由意思を持つことができるのかというのもそうですね。

茂木:その証拠として、刑法で自由意思がないと懲役とか課せない。企業に対して、懲役を課せない。LLMに意志を持ったら、懲役を課すことができるようになるのかな。「お前、懲役3年だ!」と。ありうるよね。この辺とかいっぱい論文があるんだよ。

ChapterⅤ:生成AIと脳科学が変えるビジネス戦略

吉澤:ELYZAの取り組みをアピールできるところがあればと思うんですが。

野口:プラットフォーマーのLLMだけに依存していると、いざとなったときにどうなるかわからない。小型で電力も少なくサステナブルで、ユースケースによってはオンプレでも実装できるという「企業として使いやすいモデル」のニーズは高まっていくと思っています。日本企業が作るLLMも、選択肢の一つにしっかりなっていくような世界を目指して、ELYZAもモデル開発や社会実装を引き続き頑張ってまいります。

吉澤:うちは、AIに対する取り組みを最近やっていて、「特徴量エンジニアリング」のリリースをしています。生成AIによるUIデザインと画面レイアウトのアウトプットをコントロールする技術を開発しているんですけれども、簡単にいうと、大量のデータソースを使わないで、ある特徴のあるデータを入れると良いものが作れるという。

こういう2つの取り組みを我々はやっていますというところで。

今後の具体的な戦略として僕の推測があるのですが、それを基に野口さんと茂木さんに聞いてみたいなと。

吉澤:今後についてどう考えられますか?

野口:音声インターフェース(VUI / Voice User Interface)が本格的というか、無茶苦茶ナチュラルすぎる、めちゃくちゃ感情表現、音声合成ができていて。VUIが普通になってきている。あとはパーソナライズという観点では、適切な答えを出すという能力もさることながら、その理由付け「なぜそれが良いんですか」「こういう理由でいいんですよ」というのがリッチになってきているので。それが大きな変化かなと思いますね。

吉澤:基本的なアウトプットの質が高くなっている。

野口:分析結果に対する解釈が非常にリッチになり、受け取った側が納得しやすい。特に消費者に対するパーソナライズ。

茂木:基本的にシンギュラリティへのロードマップって分からないんですよね。

やっぱり、例えば、ブロックチェーンとかWeb3とか、NFTとか過去起こって消えた、いや完全に消えたかは分からないですけど、NFTとかそのバブルを見ていると、なかなか生成AIが本当の意味で定着するのも難しいなと思っている。なかなかバラ色の未来に行けない気がしている。この問題はみんなでちゃんと考えたほうがいいと思う。「なんでブロックチェーン駄目だったんだろう」とか、「Web3、なんで駄目だったんだろう」というのはちゃんと考えたほうがいい。

野口:生成AI時代にWeb3が復活するという話もある。あと、生成AIはアプリケーションには入ってきてはいるので、一定の定着はあると考えられますよね。

茂木:それがどれくらいの付加価値になるかというところなんですよね。コモディティ化された生成AIにどれくらいお金を払うのか。なかなか難しいですよね。それこそAIじゃないと分析しきれない。本当にエキサイティングな時代だなと。

次の転機はいつなのか?

吉澤:答えはないんだろうなと思いますが。

野口:私はGPT10になった時に、どれくらいになるか。今でもすごい精度なのですが、10になった時にどうなるか。

吉澤:4、5年後位ですかね。茂木さんはどうですか?

茂木:すごく大胆なことを言いますけど、脳は情報の量子コンピュータ(※3)である可能性が極めて高いと僕は思っているんですが、次の転機は量子コンピュータができたときじゃないですか?

量子コンピュータってQEC(Quantum Error Correction)(※4)が大問題になっていて、ある時ハーバード大学でブレイクスルー(※5)があったんですけど、どうもそういうことじゃないと思うんですよね。なんで量子コンピュータでエラー補正が行われなくちゃいけないと思っているかというと、温度が上がりノイズが増えていくと、とにかくなるべく冷やしてそういうことが起こらないようにしようとアプローチしているんだと思うんだよ。

おそらく俺たちの脳って常温の量子コンピュータなんじゃないかと。

でもそのロジックをいかに導くかというのがグランドチャレンジだと思っていて、それはかなり難しい、それはかなり先ですね。

IBMとかグーグルとかしかやっていない。

量子コンピュータは本筋じゃないですか?

(※3) 量子コンピュータとは

量子力学の原理を計算に応用したコンピュータ。

量子力学的な重ね合わせの状態は非常にデリケートで保つのが難しいことから、スーパーコンピュータでも実現が難しいとされています。

(※4)QECとは

QECは量子コンピュータの実用化に向けて、不可欠な技術とされています。QECは量子エラー訂正(Quantum Error Correction)と呼ばれる、量子コンピュータにおける情報の正確な処理と長期的な保持を可能にするための重要な技術です。量子ビットが非常に不安定で環境からの影響を受けやすいことから誤りが生じやすいのですが、このQECはそれらの誤りを検出し、訂正する仕組みです。

(※5)ハーバード大学でのブレイクスルーについて

2023年末に、量子コンピュータの運用で最大の課題とされる「計算エラー」の克服に繋がる実験に成功したという発表がありました。エラー訂正の出ない状態を目指していく中で、この実験に成功したことは、量子コンピュータがスケールすることができる可能性を示しました。

参考記事:日本経済新聞「量子コンピューター、計算時の課題克服 米ハーバード大」https://www.nikkei.com/article/DGXZQOUC070WF0X01C23A2000000/

吉澤:10年後には対応できるんですかね?

茂木:残念ながら10年では対応できないと思うんだよな。だから100年後にタイムトラベルして「量子コンピュータどうなった?」って真っ先に聞いてみたいよね。

サマリー

今回、前編・後編にわたり、様々な可能性が示唆され、かなり充実した議論が行われました。

- AIがAGIやASIに進化すると、AI自身しか理解できない言語が生まれる可能性

- AIが人間に理解できない決定を行う、説明不能なAIが社会で台頭してくる可能性

- AIが人間の「自己意識」に到達するのか

- 自由意志の実装が大きな課題になり、AIが自己意識を持つことで倫理的問題が生じる可能性

- 生成AIがビジネスに与える影響として、特にVUI(音声ユーザーインターフェース)の進化が注目され、パーソナライズがさらに強化される

- 量子コンピュータの進展が次の大きな転機になる可能性

近年の生成AIの進化は目覚ましいものがあり、今後さらなる進化を遂げていくと考えられます。これらの様々な可能性を知り、ビジネスをグロースさせる一助としてどういった技術を取り入れていくか、考えていくのもまた、これからの時代欠かせないものとなっていくのではないかと思います。

AIも念頭に置いて、自社のアプリやシステムのリニューアル、または新規開発を検討されている方は是非、弊社までご相談ください。生成AIを活用し、特徴量エンジニアリングによって、UIデザイン、画面レイアウトのアウトプットをコントロールした技術事例はこちら。